Stories

-

![الحرب على إيران ومقتل خامنئي]()

الحرب على إيران ومقتل خامنئي

RT STORIES

لحظة بلحظة.. الحرب الأمريكية-الإسرائيلية على إيران تتواصل والتصعيد يهز الشرق الأوسط

![لحظة بلحظة.. الحرب الأمريكية-الإسرائيلية على إيران تتواصل والتصعيد يهز الشرق الأوسط]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الجيش الأمريكي استهلك 5.6 مليار دولار ذخائر في يومين من هجومه على إيران

![الجيش الأمريكي استهلك 5.6 مليار دولار ذخائر في يومين من هجومه على إيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"وول ستريت جورنال": مستشارو ترامب ينصحونه بإيجاد مخرج من الحرب ضد إيران

!["وول ستريت جورنال": مستشارو ترامب ينصحونه بإيجاد مخرج من الحرب ضد إيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الحرس الثوري الإيراني: من الآن فصاعدا لن يتم إطلاق أي صاروخ برأس حربي يقل وزنه عن طن واحد

![الحرس الثوري الإيراني: من الآن فصاعدا لن يتم إطلاق أي صاروخ برأس حربي يقل وزنه عن طن واحد]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

إيران تشهد تجمعات حاشدة في مراسم مبايعة المرشد الأعلى الجديد (صور+فيديو)

![إيران تشهد تجمعات حاشدة في مراسم مبايعة المرشد الأعلى الجديد (صور+فيديو)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

لحظة استهداف مدرسة إيرانية أسفر عن مقتل أكثر من 165 شخصا

![لحظة استهداف مدرسة إيرانية أسفر عن مقتل أكثر من 165 شخصا]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

رئيس منظمة الطاقة الذرية الإيرانية: لن نتوقف عن تطوير التكنولوجيا النووية

![رئيس منظمة الطاقة الذرية الإيرانية: لن نتوقف عن تطوير التكنولوجيا النووية]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

إعلام إسرائيلي: تدمير أسطول طائرات فيلق القدس في مطار مهرآباد (فيديو)

![إعلام إسرائيلي: تدمير أسطول طائرات فيلق القدس في مطار مهرآباد (فيديو)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

البحرين.. بدء محاكمة متهمين بالخيانة العظمى

![البحرين.. بدء محاكمة متهمين بالخيانة العظمى]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الخارجية الإيرانية: إيران لم تشن هجمات على قبرص وتركيا وأذربيجان

![الخارجية الإيرانية: إيران لم تشن هجمات على قبرص وتركيا وأذربيجان]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

بوتين يهنئ مجتبى خامنئي بانتخابه مرشدا أعلى لإيران

![بوتين يهنئ مجتبى خامنئي بانتخابه مرشدا أعلى لإيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"أين هم الحوثيون؟.. الحرس الثوري يكشف "المهمة الموكلة" لأنصار الله

!["أين هم الحوثيون؟.. الحرس الثوري يكشف "المهمة الموكلة" لأنصار الله]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

إيران: هدف أمريكا من الهجوم العسكري هو النفط وثقتنا بها انتهت منذ انقلاب 1953

![إيران: هدف أمريكا من الهجوم العسكري هو النفط وثقتنا بها انتهت منذ انقلاب 1953]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"روساتوم": الوضع حول محطة "بوشهر" في إيران صعب ونبدأ بإجلاء أفراد العائلات وبعض العاملين قريبا

!["روساتوم": الوضع حول محطة "بوشهر" في إيران صعب ونبدأ بإجلاء أفراد العائلات وبعض العاملين قريبا]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الصين تؤكد التزامها بدعم الاستقرار في منطقة الخليج

![الصين تؤكد التزامها بدعم الاستقرار في منطقة الخليج]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

غراهام يحذر إسرائيل من استهداف نفط إيران

![غراهام يحذر إسرائيل من استهداف نفط إيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الجيش الإسرائيلي: استهداف مواقع إطلاق صواريخ في إيران ومقرات لقوات الأمن الداخلي والبسيج

![الجيش الإسرائيلي: استهداف مواقع إطلاق صواريخ في إيران ومقرات لقوات الأمن الداخلي والبسيج]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"بابكو إنرجيز" تعلن القوة القاهرة بعد هجوم إيراني على مصفاتها في البحرين

!["بابكو إنرجيز" تعلن القوة القاهرة بعد هجوم إيراني على مصفاتها في البحرين]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

ضباط إسرائيليون: نستعد لشهر من القتال في إيران

![ضباط إسرائيليون: نستعد لشهر من القتال في إيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

تقرير: إطلاق ما بين 300 و400 مليون برميل من الاحتياطيات النفطية سيكون "مناسبا" لتهدئة صدمة الأسعار

![تقرير: إطلاق ما بين 300 و400 مليون برميل من الاحتياطيات النفطية سيكون "مناسبا" لتهدئة صدمة الأسعار]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

10 هجمات على سفن بمضيق هرمز خلال أسبوع وحركة الناقلات تتراجع 90%

![10 هجمات على سفن بمضيق هرمز خلال أسبوع وحركة الناقلات تتراجع 90%]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

لحظة بلحظة..الحرب الأمريكية-الإسرائيلية على إيران بيومها العاشر: مجتبى خامنئي مرشدا والتصعيد متواصل

![لحظة بلحظة..الحرب الأمريكية-الإسرائيلية على إيران بيومها العاشر: مجتبى خامنئي مرشدا والتصعيد متواصل]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

زيلينسكي يرسل مسيرات وفريقا من الخبراء إلى الأردن

![زيلينسكي يرسل مسيرات وفريقا من الخبراء إلى الأردن]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"القضية هي النفط فقط".. إيران تلتقط لحظة صراحة أمريكية نادرة!

!["القضية هي النفط فقط".. إيران تلتقط لحظة صراحة أمريكية نادرة!]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

وانغ يي حول الصراع في الشرق الأوسط: قوة القبضة القوية لا تعني بالضرورة قوة الحجة

![وانغ يي حول الصراع في الشرق الأوسط: قوة القبضة القوية لا تعني بالضرورة قوة الحجة]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

أسعار النفط تقترب من حاجز 120 دولارا للبرميل

![أسعار النفط تقترب من حاجز 120 دولارا للبرميل]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

ويتكوف وكوشنر يتوجهان إلى إسرائيل غدا لبحث الخلاف حول ضربات إيران

![ويتكوف وكوشنر يتوجهان إلى إسرائيل غدا لبحث الخلاف حول ضربات إيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

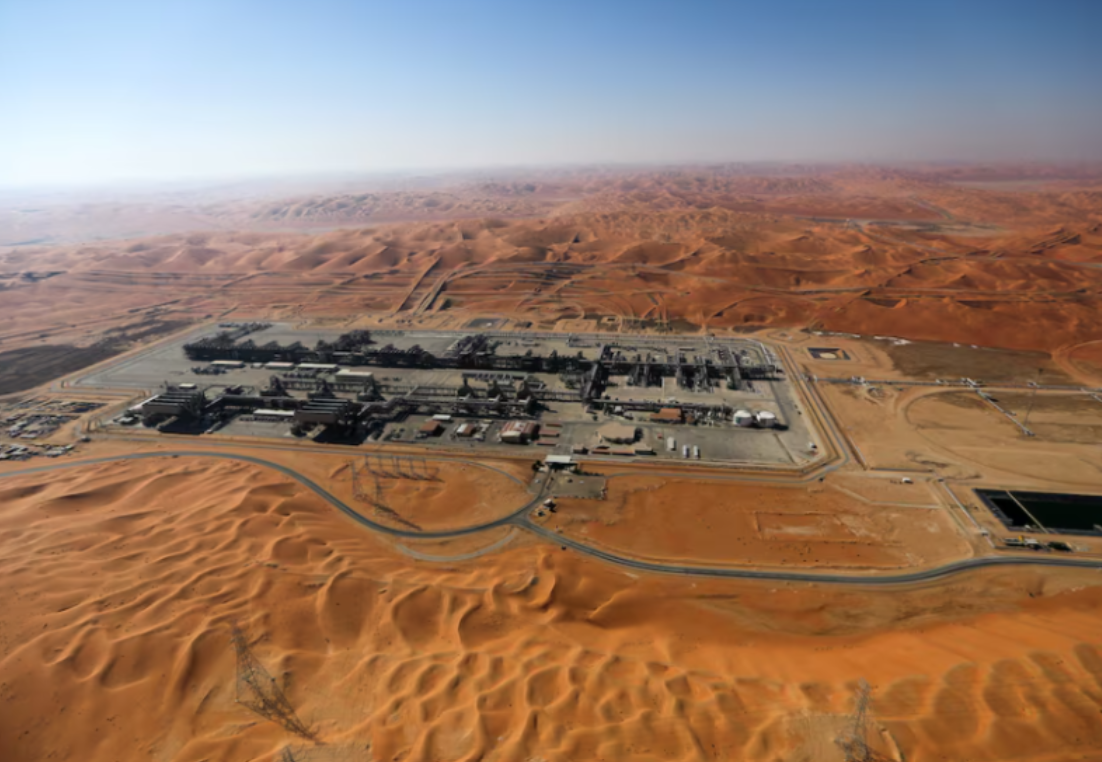

الدفاع السعودية تعلن اعتراض وتدمير 4 مسيرات متجهة إلى حقل شيبة

![الدفاع السعودية تعلن اعتراض وتدمير 4 مسيرات متجهة إلى حقل شيبة]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

وسائل إعلام: سقوط صاروخ "باتريوت" أمريكي على منطقة سكنية في البحرين

![وسائل إعلام: سقوط صاروخ "باتريوت" أمريكي على منطقة سكنية في البحرين]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

ترامب: قرار الحرب على إيران مشترك مع نتنياهو والكلمة الأخيرة لي

![ترامب: قرار الحرب على إيران مشترك مع نتنياهو والكلمة الأخيرة لي]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

محذرة من توسع دائرة التصعيد.. السعودية: إيران لم تطبق تصريحات رئيسها على أرض الواقع

![محذرة من توسع دائرة التصعيد.. السعودية: إيران لم تطبق تصريحات رئيسها على أرض الواقع]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More![الحرب على إيران ومقتل خامنئي]() الحرب على إيران ومقتل خامنئي

الحرب على إيران ومقتل خامنئي

-

![نبض الملاعب]()

نبض الملاعب

RT STORIES

زلزال محتمل في البرنابيو.. بيريز يدرس تغيير مدرب ريال مدريد

![زلزال محتمل في البرنابيو.. بيريز يدرس تغيير مدرب ريال مدريد]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

23 بطاقة حمراء.. مشاجرة عنيفة بين اللاعبين في مباراة نهائية بالبرازيل (فيديو)

![23 بطاقة حمراء.. مشاجرة عنيفة بين اللاعبين في مباراة نهائية بالبرازيل (فيديو)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

كم يبلغ أجر ياسر إبراهيم مقابل هذا المقلب؟ (فيديو)

#اسأل_أكثر #Question_MoreRT STORIES

صدام "مصري مصري" مبكر بين صلاح ومرموش

![صدام "مصري مصري" مبكر بين صلاح ومرموش]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

شاهد.. عزف النشيد الروسي في دورة الألعاب البارالمبية 2026

![شاهد.. عزف النشيد الروسي في دورة الألعاب البارالمبية 2026]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

مناطحة "الرؤوس".. المصري ياسر إبراهيم يكشف سبب مشادته مع ميسي (فيديو)

![مناطحة "الرؤوس".. المصري ياسر إبراهيم يكشف سبب مشادته مع ميسي (فيديو)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

بعد "هروب" بعضهن.. ترامب يعلق على أزمة لاعبات إيران عقب تعرضهن لاتهامات بالخيانة

![بعد "هروب" بعضهن.. ترامب يعلق على أزمة لاعبات إيران عقب تعرضهن لاتهامات بالخيانة]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

لاعب يتعرض للطعن في "منطقة حساسة" من شقيق خصمه داخل ملعب لكرة القدم

![لاعب يتعرض للطعن في "منطقة حساسة" من شقيق خصمه داخل ملعب لكرة القدم]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

بعد وصفهن بـ"الخائنات".. انباء عن "هروب" لاعبات من منتخب إيران للسيدات

![بعد وصفهن بـ"الخائنات".. انباء عن "هروب" لاعبات من منتخب إيران للسيدات]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

شاهد.. "أشرس مقاتل" يفوز بـ لقب "الأسوأ"

![شاهد.. "أشرس مقاتل" يفوز بـ لقب "الأسوأ"]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

بعد التوقف بسبب الحرب على إيران.. مؤسسة دوري نجوم قطر تكشف موعد استئناف مباريات كرة القدم

![بعد التوقف بسبب الحرب على إيران.. مؤسسة دوري نجوم قطر تكشف موعد استئناف مباريات كرة القدم]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

أول تعليق من المصري حمزة عبد الكريم على هدفه الأول بقميص برشلونة

![أول تعليق من المصري حمزة عبد الكريم على هدفه الأول بقميص برشلونة]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

بسبب تغريدات مسيئة للنادي.. ليفربول يتقدم بشكوى رسمية لإيلون ماسك

![بسبب تغريدات مسيئة للنادي.. ليفربول يتقدم بشكوى رسمية لإيلون ماسك]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

محمد صلاح يخطف الأضواء ويثير التكهنات بفيديو مع ابنته

![محمد صلاح يخطف الأضواء ويثير التكهنات بفيديو مع ابنته]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

تقارير تحسم موقف مبابي من مباراة ريال مدريد ومانشستر سيتي في دوري الأبطال

![تقارير تحسم موقف مبابي من مباراة ريال مدريد ومانشستر سيتي في دوري الأبطال]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

مفاجأة.. نجم من الاتحاد السعودي على رادار ليفربول لخلافة محمد صلاح

![مفاجأة.. نجم من الاتحاد السعودي على رادار ليفربول لخلافة محمد صلاح]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

برشلونة يتغنى بالظهور الأول لحمزة عبد الكريم

![برشلونة يتغنى بالظهور الأول لحمزة عبد الكريم]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More![نبض الملاعب]() نبض الملاعب

نبض الملاعب

-

![ضربات إسرائيلية على لبنان]()

ضربات إسرائيلية على لبنان

RT STORIES

ساعر: هجمات حزب الله من لبنان تفوق ضربات إيران على إسرائيل خلال أسبوع

![ساعر: هجمات حزب الله من لبنان تفوق ضربات إيران على إسرائيل خلال أسبوع]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

حزب الله يعلن استهداف مراكز إسرائيلية للمرة الأولى ويلتحم مع قوات متوغلة بالخيام

![حزب الله يعلن استهداف مراكز إسرائيلية للمرة الأولى ويلتحم مع قوات متوغلة بالخيام]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

مشاهد للبيت الثقافي الروسي المدمر جراء غارات جوية إسرائيلية على لبنان

![مشاهد للبيت الثقافي الروسي المدمر جراء غارات جوية إسرائيلية على لبنان]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

حزب الله يعلن التصدي لإنزال إسرائيلي للمرة الثانية في شرق لبنان

![حزب الله يعلن التصدي لإنزال إسرائيلي للمرة الثانية في شرق لبنان]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

نيران مشتعلة وركام ومبان متضررة جراء قصف إسرائيلي على الضاحية الجنوبية لبيروت

![نيران مشتعلة وركام ومبان متضررة جراء قصف إسرائيلي على الضاحية الجنوبية لبيروت]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

السفارة الأمريكية في بيروت تحذر رعاياها

![السفارة الأمريكية في بيروت تحذر رعاياها]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الجيش الإسرائيلي يستعد لإدخال الفرقة 162 إلى لبنان

![الجيش الإسرائيلي يستعد لإدخال الفرقة 162 إلى لبنان]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الرئيس اللبناني: اعتداءات إسرائيل لن تحقق أهدافها وموقفنا ثابت بحصر السلاح

![الرئيس اللبناني: اعتداءات إسرائيل لن تحقق أهدافها وموقفنا ثابت بحصر السلاح]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الجيش الإسرائيلي يبدأ بشن غارات على فروع "القرض الحسن" في بيروت (فيديو + صور)

![الجيش الإسرائيلي يبدأ بشن غارات على فروع "القرض الحسن" في بيروت (فيديو + صور)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الجيش اللبناني يقطع طرقات بيروت وصيدا بعد إنذار إسرائيلي باستهداف "القرض الحسن" (فيديو)

![الجيش اللبناني يقطع طرقات بيروت وصيدا بعد إنذار إسرائيلي باستهداف "القرض الحسن" (فيديو)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

لبنان.. إصابة 11 سوريا بغارة استهدفت مزرعة جنوبي البلاد

![لبنان.. إصابة 11 سوريا بغارة استهدفت مزرعة جنوبي البلاد]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

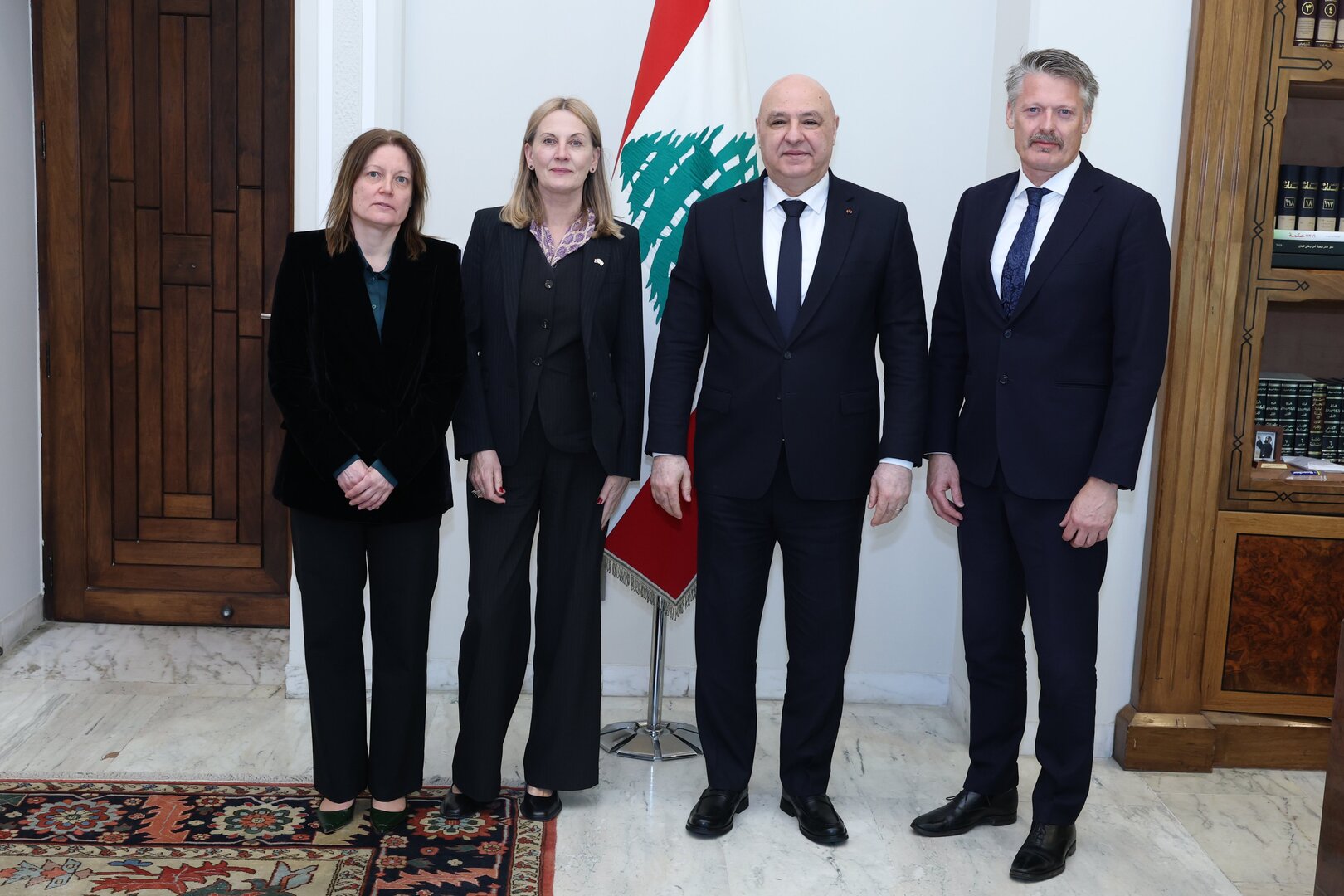

نواف سلام: نعمل يوميا لوقف الحرب ومنفتحون على كل صيغ التفاوض مع إسرائيل برعاية دولية

![نواف سلام: نعمل يوميا لوقف الحرب ومنفتحون على كل صيغ التفاوض مع إسرائيل برعاية دولية]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الجيش الإسرائيلي يصدر إنذارا لسكان الضاحية الجنوبية: سنعمل بقوة ضد البنى التحتية لجمعية القرض الحسن

![الجيش الإسرائيلي يصدر إنذارا لسكان الضاحية الجنوبية: سنعمل بقوة ضد البنى التحتية لجمعية القرض الحسن]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"هيومن رايتس ووتش" تتهم إسرائيل باستخدام الفوسفور الأبيض في لبنان

!["هيومن رايتس ووتش" تتهم إسرائيل باستخدام الفوسفور الأبيض في لبنان]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

لحظة بلحظة.. إسرائيل تواصل حربها على لبنان وحزب الله يواجه قوة متوغلة جنوبا

![لحظة بلحظة.. إسرائيل تواصل حربها على لبنان وحزب الله يواجه قوة متوغلة جنوبا]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

قتلى بغارات إسرائيلية متجددة على لبنان وحزب الله يشتبك مع قوة إسرائيلية قرب العديسة

![قتلى بغارات إسرائيلية متجددة على لبنان وحزب الله يشتبك مع قوة إسرائيلية قرب العديسة]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More![ضربات إسرائيلية على لبنان]() ضربات إسرائيلية على لبنان

ضربات إسرائيلية على لبنان

-

![تسوية النزاع الأوكراني]()

تسوية النزاع الأوكراني

RT STORIES

زيلينسكي: تأجيل مفاوضات أوكرانيا بسبب تصاعد الأزمة في إيران

![زيلينسكي: تأجيل مفاوضات أوكرانيا بسبب تصاعد الأزمة في إيران]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

"نوفوستي": لا توجد معلومات لدى تركيا بشأن مفاوضات حول أوكرانيا في 11 مارس

!["نوفوستي": لا توجد معلومات لدى تركيا بشأن مفاوضات حول أوكرانيا في 11 مارس]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More![تسوية النزاع الأوكراني]() تسوية النزاع الأوكراني

تسوية النزاع الأوكراني

-

![فيديوهات]()

فيديوهات

RT STORIES

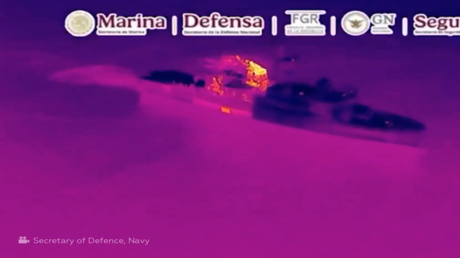

البحرية المكسيكية تضبط طنين من الكوكايين

![البحرية المكسيكية تضبط طنين من الكوكايين]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

ماكرون يتفقد الجيش الفرنسي على متن حاملة الطائرات شارل ديغول قبالة سواحل جزيرة كريت

![ماكرون يتفقد الجيش الفرنسي على متن حاملة الطائرات شارل ديغول قبالة سواحل جزيرة كريت]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

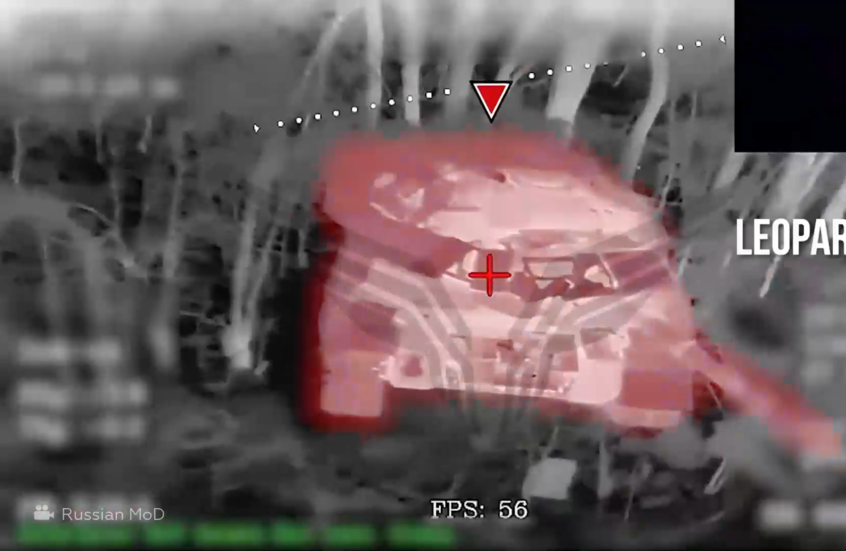

بينها دبابة ألمانية.. الدفاع الروسية تنشر لقطات لتدمير مركبات ومعدات أوكرانية

![بينها دبابة ألمانية.. الدفاع الروسية تنشر لقطات لتدمير مركبات ومعدات أوكرانية]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

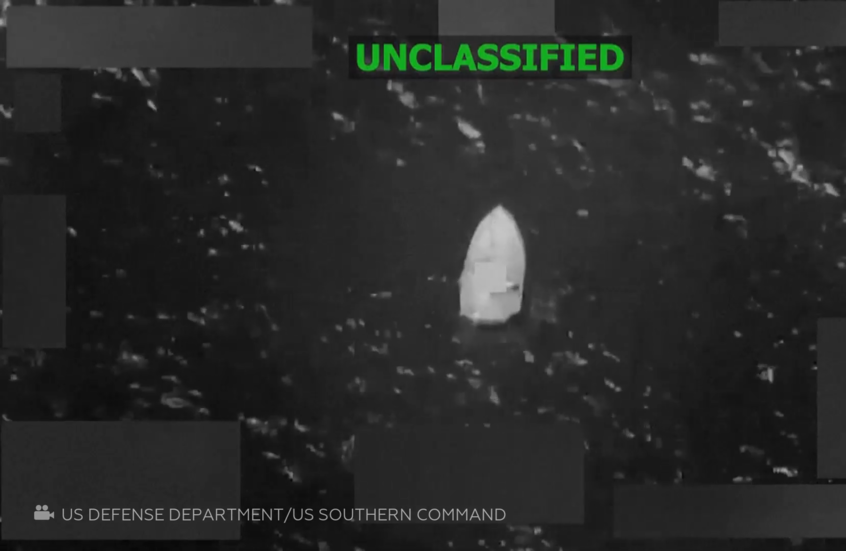

ضربة أمريكية تستهدف زورقا في المحيط الهادئ

![ضربة أمريكية تستهدف زورقا في المحيط الهادئ]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More![فيديوهات]() فيديوهات

فيديوهات

-

![العملية العسكرية الروسية في أوكرانيا]()

العملية العسكرية الروسية في أوكرانيا

RT STORIES

الجيش الروسي يحرر بلدة أخرى في دونيتسك

![الجيش الروسي يحرر بلدة أخرى في دونيتسك]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_MoreRT STORIES

الدعم الغربي على المحك: كييف تخشى أن تدفع ثمن حرب إيران ودعوات لزيلينسكي للتفاوض المباشر مع موسكو

![الدعم الغربي على المحك: كييف تخشى أن تدفع ثمن حرب إيران ودعوات لزيلينسكي للتفاوض المباشر مع موسكو]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More![العملية العسكرية الروسية في أوكرانيا]() العملية العسكرية الروسية في أوكرانيا

العملية العسكرية الروسية في أوكرانيا

-

![مفاجأة.. مبابي يرتبط بصديقة سابقة لأحد زملائه في ريال مدريد (صور)]()

مفاجأة.. مبابي يرتبط بصديقة سابقة لأحد زملائه في ريال مدريد (صور)

RT STORIES

مفاجأة.. مبابي يرتبط بصديقة سابقة لأحد زملائه في ريال مدريد (صور)

![مفاجأة.. مبابي يرتبط بصديقة سابقة لأحد زملائه في ريال مدريد (صور)]() #اسأل_أكثر #Question_More

#اسأل_أكثر #Question_More

دراسة مقلقة تكشف تدريب ذكاء اصطناعي على صور الاعتداء الجنسي على الأطفال!

كشفت دراسة جديدة أن آلاف صور الاعتداء الجنسي على الأطفال مخبأة داخل مؤسسة شهيرة لمولدات صور الذكاء الاصطناعي.

وعثر مرصد ستانفورد للإنترنت على أكثر من 3200 صورة للاعتداء الجنسي على الأطفال في قاعدة بيانات الذكاء الاصطناعي العملاقة LAION، وهو فهرس للصور والتسميات التوضيحية عبر الإنترنت استُخدم لتدريب صنّاع صور الذكاء الاصطناعي مثل Stable Diffusion.

وعملت مجموعة المراقبة مع المركز الكندي لحماية الطفل وغيره من الجمعيات الخيرية المناهضة للإساءة، لتحديد المواد غير القانونية والإبلاغ عن روابط الصور الأصلية إلى جهات إنفاذ القانون. وتم التأكد من أن أكثر من 1000 صورة من الصور المشتبه بها تشمل مواد اعتداء جنسي على الأطفال.

وكتب الباحثون: "وجدنا أن امتلاك مجموعة بيانات LAION-5B المأهولة حتى أواخر عام 2023، يعني حيازة آلاف الصور غير القانونية".

وعشية إصدار تقرير مرصد ستانفورد للإنترنت يوم الأربعاء، قالت LAION إنها أزالت مجموعات البيانات الخاصة بها مؤقتا.

وقالت LAION، التي تمثل الشبكة المفتوحة للذكاء الاصطناعي واسعة النطاق غير الربحية، في بيان لها: "إن لديها سياسة عدم التسامح مطلقا مع المحتوى غير القانوني، وفي ظل الحذر الشديد، قمنا بإزالة مجموعات بيانات LAION للتأكد من أنها آمنة قبل إعادة نشرها".

العام القادم يشهد إطلاق أول حاسوب عملاق على مستوى الدماغ البشري!

وفي حين أن الصور لا تمثل سوى جزء صغير من مؤشر LAION الذي يبلغ حوالي 5.8 مليار صورة، تقول مجموعة ستانفورد إنها ربما تؤثر على قدرة أدوات الذكاء الاصطناعي على توليد مخرجات ضارة وتعزيز الإساءة السابقة للضحايا الحقيقيين.

ويقول الباحثون إن هذه الصور نفسها جعلت من السهل على أنظمة الذكاء الاصطناعي إنتاج صور واقعية وصريحة لأطفال مزيفين، بالإضافة إلى تحويل صور وسائل التواصل الاجتماعي لمراهقين حقيقيين يرتدون ملابس كاملة، إلى عراة، الأمر الذي أثار قلق المدارس وجهات إنفاذ القانون في جميع أنحاء العالم.

وحتى وقت قريب، اعتقد الباحثون في مجال مكافحة إساءة الاستخدام، أن الطريقة الوحيدة التي تنتج بها بعض أدوات الذكاء الاصطناعي غير الخاضعة للرقابة صورا مسيئة للأطفال، هي من خلال الجمع بين ما تعلمته من فئتين منفصلتين من الصور عبر الإنترنت: المواد الإباحية للبالغين والصور الحميدة للأطفال.

وقال ديفيد ثيل، كبير خبراء التكنولوجيا في مرصد ستانفورد للإنترنت، والذي كتب التقرير، إن هذه مشكلة ليست سهلة الإصلاح، وتعود جذورها إلى العديد من مشاريع الذكاء الاصطناعي التوليدية التي "تم طرحها بشكل فعال في السوق" وإتاحتها على نطاق واسع، لأن هذا المجال تنافسي للغاية.

يذكر أن LAION من بنات أفكار الباحث والمعلم الألماني، كريستوف شومان، الذي قال في وقت سابق من هذا العام إن جزءا من السبب وراء جعل قاعدة البيانات المرئية الضخمة هذه متاحة للجمهور، هو ضمان عدم التحكم في مستقبل تطوير الذكاء الاصطناعي من قبل شركات قوية.

المصدر: الغارديان

التعليقات